En cierto sentido, cualquier arquitectura puede ser una arquitectura para aficionados. Incluso en los días de las computadoras de un millón de dólares, había aficionados al software que encontraban formas de ingresar a los laboratorios de computación de la universidad, a menudo ofreciéndose para ayudar de alguna manera. Hoy en día, hay computadoras mucho más potentes que son lo suficientemente baratas como para que los aficionados estén dispuestos a desarmarlas. Pero hay algunas arquitecturas de computadora específicamente destinadas a los aficionados.

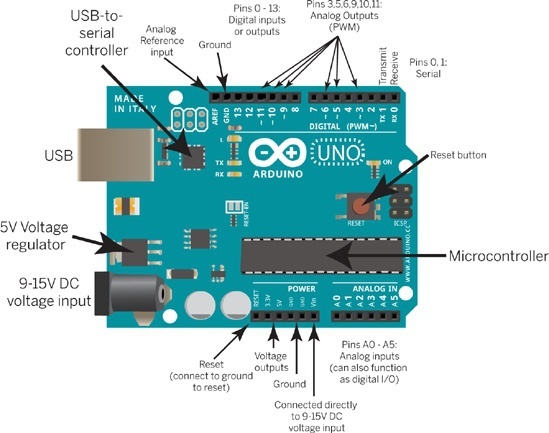

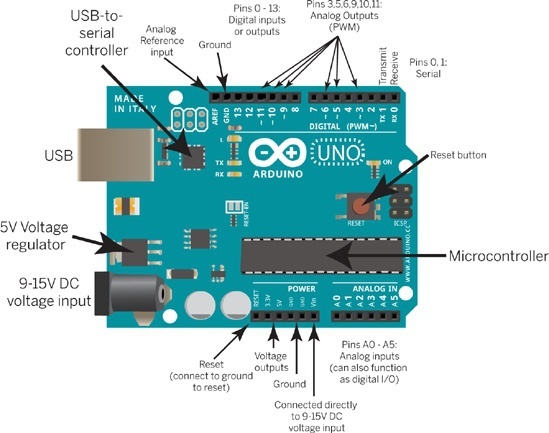

Por mucho, la computadora más popular específicamente para los aficionados es el Arduino. Es una placa de circuito, no solo un procesador. Alrededor de los bordes del tablero hay conectores. En el borde corto a la izquierda de la imagen se encuentra la entrada de alimentación, que puede conectarse a una fuente de alimentación conectada a la pared o a una batería para un dispositivo móvil como un robot, y un conector USB utilizado principalmente para descargar programas de una computadora de escritorio o portátil. En los bordes largos hay conectores para cables individuales conectados a sensores remotos (para luz, calor, estar cerca de una pared, tocar otro objeto, etc.) o actuadores (motores paso a paso, luces, zumbadores, etc.).

Un aspecto importante del diseño de Arduino es que es libre ("libre como en libertad"). Cualquiera puede hacer e incluso vender copias del Arduino. Esto es bueno porque mantiene el precio bajo (la placa básica Arduino Uno cuesta 22 dólares) y fomenta la innovación, pero también significa que puede haber placas incompatibles similares a Arduino. (El nombre "Arduino" es una marca comercial que solo se puede utilizar con licencia de Arduino AG).

El procesador en la mayoría de los modelos Arduino es un sistema RISC de ocho bits con memoria incluida en el chip, llamado AVR, de una compañía llamada Atmel. Fue diseñado por dos (entonces) estudiantes en Noruega, llamados Alf-Egil Bogen y Vegard Wollan. Aunque oficialmente "AVR" no significa nada, se cree ampliamente que proviene del "RISC de Alf y Vegard". Hay varias versiones del procesador AVR, con diferentes velocidades, capacidades de memoria y, por supuesto, precios; hay varios modelos Arduino que utilizan los diferentes procesadores.

A diferencia de la mayoría de las computadoras ("arquitectura de von Neumann"), el AVR ("arquitectura de Harvard") separa la memoria del programa de la memoria de datos. (En realidad, tiene tres tipos de memoria: una para el programa en ejecución, otra para datos a corto plazo y otra para datos a largo plazo). La maquina analítica de Babbage también fue diseñada con una memoria de programa separada de su memoria de datos.

¿Por qué querrías más de un tipo de memoria?

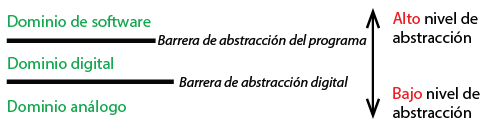

En realidad, hay dos problemas de diseño diferentes en funcionamiento en esta arquitectura. Uno está en el dominio analógico, que tiene que ver con el tipo de circuito físico utilizado. Existen muchas tecnologías de memoria, que varían en costo, velocidad y volatilidad: la memoria volátil pierde la información almacenada cuando el dispositivo está apagado, mientras que la memoria no volátil retiene la información. Así es como se usa la memoria en los chips AVR:

-

EEPROM (512 Bytes–4kBytes) es no volátil y se usa para datos a muy largo plazo, como un archivo en el disco de una computadora, excepto que solo hay una pequeña cantidad disponible. Los programas en Arduino deben solicitar explícitamente el uso de esta memoria, con una biblioteca EEPROM.

- El nombre significa memoria de solo lectura programable y borrable eléctricamente (Electrically Erasable Programmable Read-Only Memory, en inglés), que suena como una contradicción en terminos. En los primeros días de las computadoras basadas en transistores, había dos tipos de memoria, volátil (memoria de acceso aleatorio o Random Access Memory / RAM, en inglés) y no volátil (memoria de solo lectura o Read-Only Memory / ROM, en inglés). Los valores almacenados en las primeras ROM tenian que ser incorporados por el fabricante del chip de memoria, por lo que era costoso fabricar uno nuevo. Luego vino la memoria programable de solo lectura (Programmable Read-Only Memory / PROM, en inglés), que era de solo lectura una vez instalada en una computadora, pero que podía programarse, solo una vez, usando una máquina que solo era algo costosa. Luego vino EPROM, PROM borrable (Erasable PROM, en inglés), que podría borrarse en su totalidad al iluminarlo con una luz ultravioleta brillante, y luego reprogramarse como una PROM. Finalmente, había PROM borrable eléctricamente (Electrically Erasable PROM, en inglés), que podría borrarse mientras estaba instalado en una computadora, esencialmente equivalente a RAM, excepto que el borrado es mucho más lento que reescribir una palabra de RAM, por lo que se usa solo para valores que no van a cambiar a menudo

-

SRAM (1k–4kBytes): Esta memoria puede perder sus valores cuando la máquina está apagada; en otras palabras, es volátil. Se utiliza para datos temporales, como las variables de script en un script Snap!.

- El nombre significa memoria estática de acceso aleatorio (Static Random Access Memory, en inglés). La parte de "Acceso aleatorio" lo diferencia del almacenamiento de cinta magnética utilizado en computadoras muy antiguas, en la que tomaba mucho tiempo llegar de un extremo a otro de la cinta, por lo que solo era práctico escribir o leer datos en secuencia. Actualmente toda la memoria de la computadora es de acceso aleatorio, y el nombre "RAM" realmente significa "grabable", en lugar de solo lectura. La parte "Estática" del nombre significa que, aunque la memoria requiere energía para retener su valor, no requiere una actualización periódica como lo hace la memoria regular ("Dinámica") principal de la computadora. ("Actualizar" significa que cada cierto tiempo, la computadora tiene que leer el valor de cada palabra de memoria y reescribir el mismo valor, o de lo contrario se desvanece. Este es un buen ejemplo de circuitos de computadora cuyo trabajo es mantener la abstracción digital en la cual un valor es cero o uno, y no existe tal cosa como "desvanecimiento" o "valores intermedios". ) La RAM estática es más rápida pero más cara que la RAM dinámica; es por eso que DRAM se utiliza para las memorias muy grandes (varios gigabytes) de las computadoras de escritorio o portátiles.

-

memoria Flash (16k–256kBytes): Esta es la memoria principal, utilizada para programas y datos. Probablemente le resulte familiar la memoria flash porque se usa para las memorias USB que funcionan como almacenamiento externo portátil. Técnicamente es un tipo de EEPROM, pero con una implementación física diferente que lo hace mucho más barato (por lo que puede haber más en el Arduino), pero más complicado de usar, lo que requiere un circuito de control especial para mantener la abstracción digital.

- "Más complicado" significa, por ejemplo, que cambiar un valor de bit de 1 a 0 es fácil, pero cambiarlo de 0 a 1 es un proceso mucho más lento que implica borrar un gran bloque de memoria a todos los bits de 1 y luego reescribir los valores de los bits que no querías cambiar.

Entonces, es por eso que hay físicamente diferentes tipos de memoria en los chips AVR, pero nada de eso explica completamente la arquitectura de Harvard, en la cual la memoria se divide en programa y datos, independientemente de cuánto tiempo deben sobrevivir los datos. La razón principal para tener dos circuitos de interfaz de memoria diferentes es que le permite al procesador leer una instrucción de programa y un valor de datos al mismo tiempo. En principio, esto puede hacer que el procesador sea el doble de rápido, aunque en la práctica toda esa ganancia de velocidad no se encuentra.

Para comprender el beneficio de la lectura simultánea de instrucción y de datos, debes comprender que los procesadores a menudo se diseñan utilizando una idea llamada segmentación (pipelining). La metáfora estándar es sobre lavar la ropa cuando tienes más de una carga. Lavas la primera carga, mientras que la secadora no hace nada; después lavas la segunda carga mientras se seca la primera carga y así sucesivamente hasta la última carga. De manera similar, el procesador de una computadora incluye un sistema de circuitos para decodificar una instrucción y sistema de circuitos para hacer aritmética. Si el procesador hace una cosa a la vez, en cualquier momento el circuito de decodificación de instrucciones o el circuito aritmético no está haciendo nada. Pero si puedes leer la siguiente instrucción al mismo tiempo que se lleva a cabo la anterior, todo el procesador se mantiene ocupado.

Esta fue una explicación larga, pero todavía está muy simplificada. Por un lado, también es posible utilizar la segmentación en una arquitectura von Neumann. Y por otro lado, una arquitectura Harvard pura no permitiría que una computadora cargue programas para que se ejecute. Por lo tanto, se utilizan varios compromisos en la práctica.

Desde entonces, Atmel ha introducido una línea de procesadores de 32 bits compatibles con ARM, y Arduino tiene placas que usan ese procesador pero son compatibles con el diseño de los conectores en los bordes.

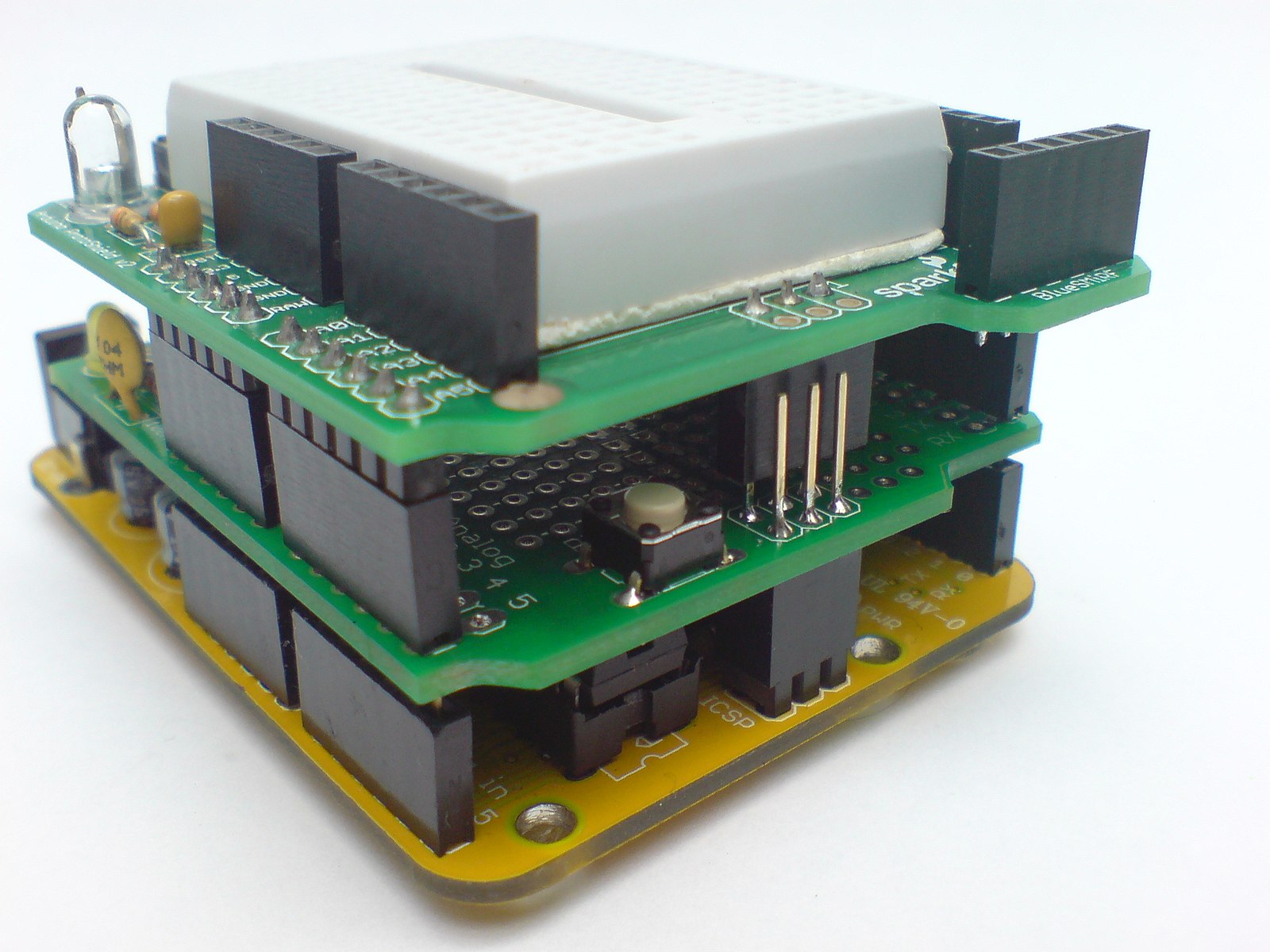

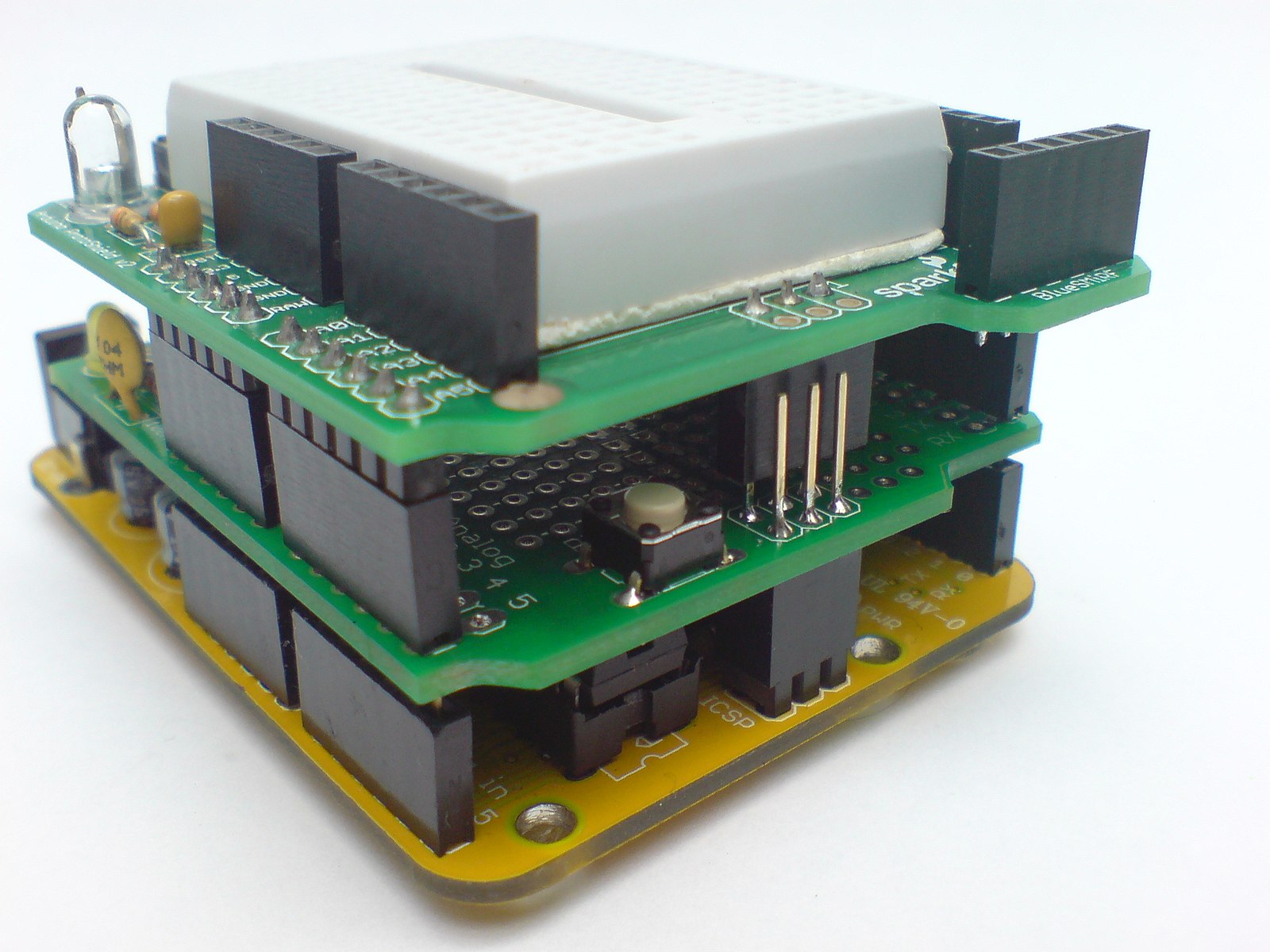

Una cosa que ha contribuido a la popularidad del Arduino entre los aficionados es la disponibilidad de complementos, que son placas de circuito auxiliar que se conectan a los conectores del borde lateral y tienen los mismos conectores en su lado superior. Los complementos agregan funciones al sistema. Algunos ejemplos son los complementos de control de motores, de Bluetooth para comunicarse con teléfonos celulares, los complementos de RFID para leer las etiquetas de productos que se encuentran dentro del embalaje de muchos productos, etc. Tanto la compañía Arduino como otros venden complementos.

Pila de placas Arduino

Imagen del usuario de Wikimedia Marlon J. Manrique, CC-BY-SA 2.0.

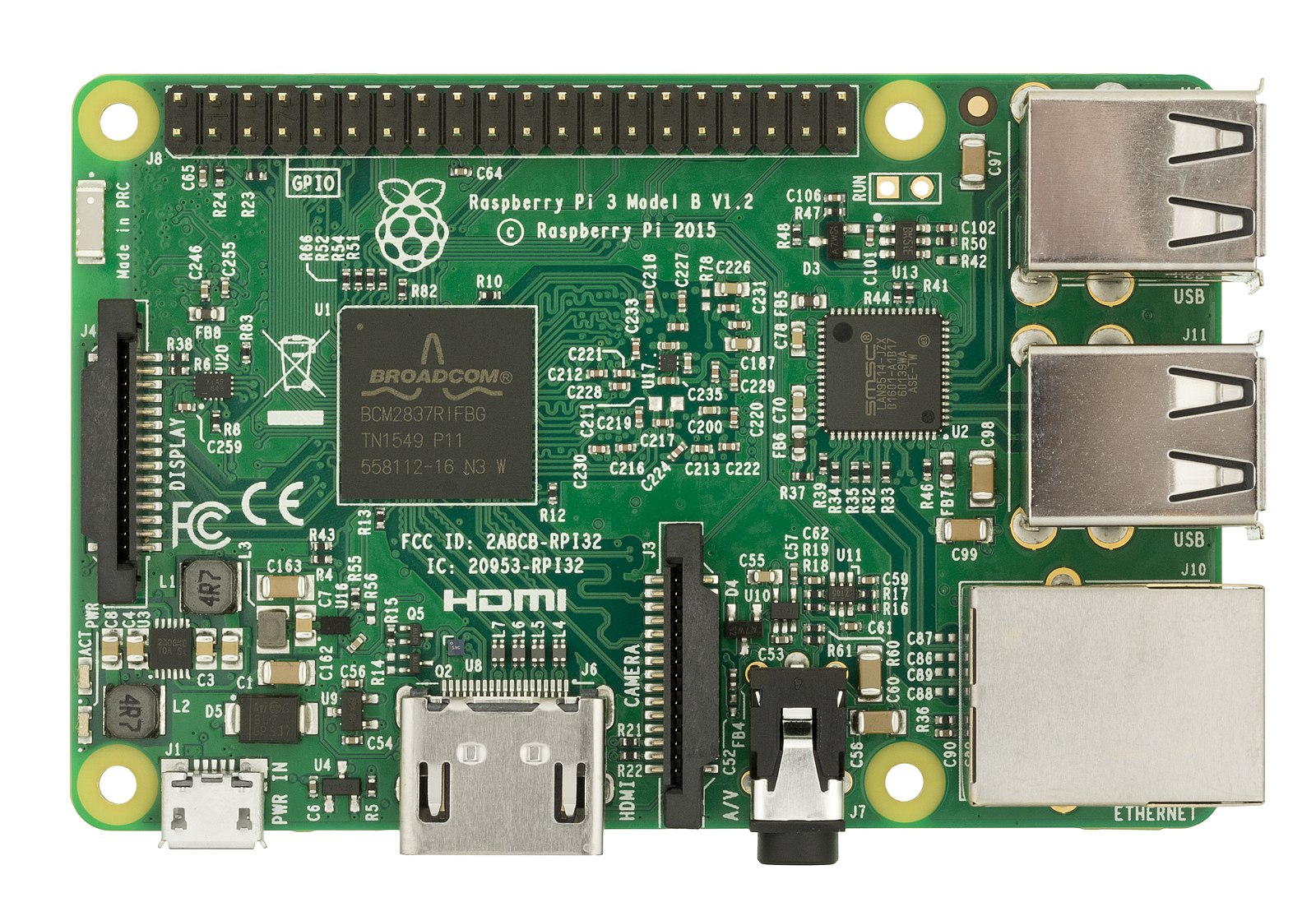

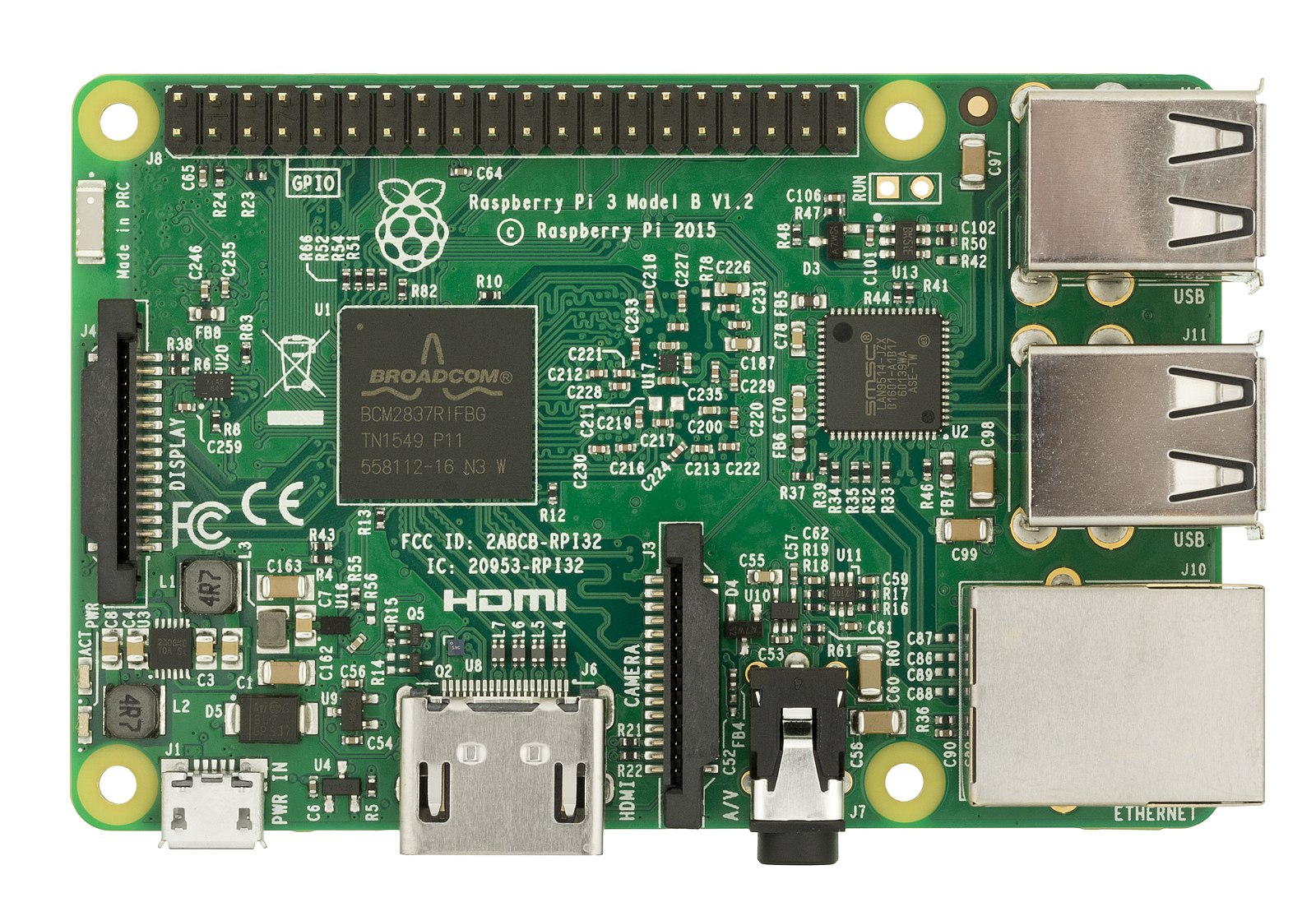

Una arquitectura de aficionados completamente diferente es la Raspberry Pi. Fue diseñada para usarse como una computadora de escritorio o portátil, pero con más acceso a su electrónica. Utiliza un procesador compatible con ARM, como la mayoría de los teléfonos celulares, pero en lugar de ejecutar el software del sistema operativo del teléfono como Android, ejecuta sistemas operativos de computadora "reales". Se envía con Linux, pero la gente ha ejecutado Windows en él.

Lo principal que lo hace emocionante es que es económico: los diferentes modelos varían en precio desde 5 hasta 35 dólares. El precio incluye solo la placa de circuito, como en la imagen, sin teclado, pantalla, mouse, adaptador de corriente o estuche. El gasto principal en los kit computadoras es la pantalla, por lo que el Pi está diseñado para conectarse a su televisor. Puedes comprar kits que incluyen un estuche mínimo, un teclado y otros complementos importantes por alrededor de 20 dólares. También puedes comprar estuches elegantes para que se vea como cualquier otra computadora, con una pantalla, por cientos de dólares.

Debido a que el Pi está destinado para uso educativo, viene con software, algunos de los cuales son gratuitos para cualquier persona, pero otros generalmente cuestan dinero para computadoras que no son Pi. Un ejemplo importante es Mathematica, que cuesta más de 200 dólares para los estudiantes (su precio más barato), pero se incluye gratis en el Pi.

Al igual que el Arduino, el Pi admite placas de circuito adicionales con elementos como sensores y módulos de comunicación inalámbrica.

Placa Raspberry Pi

Imagen de Evan Amos, a través de Wikimedia, dominio público.

. En un lenguaje de nivel más bajo como C o Java, la misma idea se escribiría como:

. En un lenguaje de nivel más bajo como C o Java, la misma idea se escribiría como: