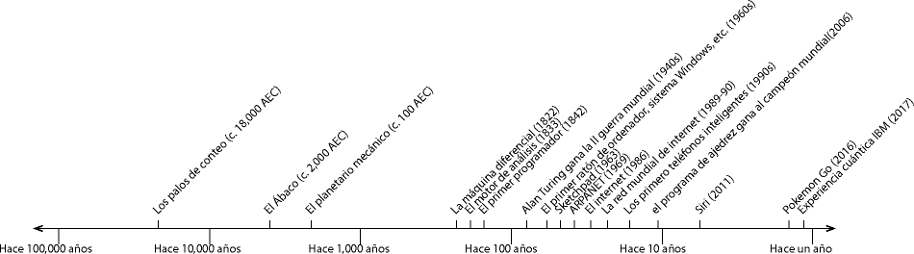

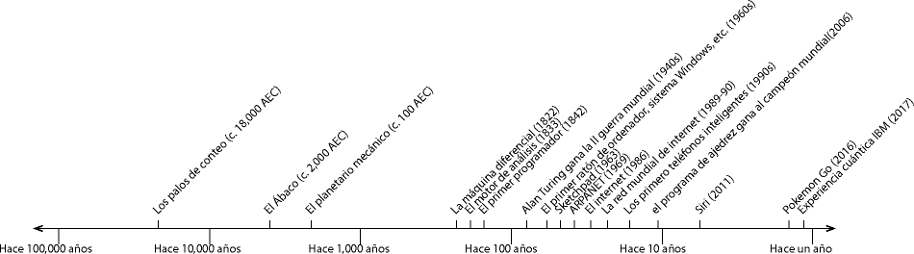

¿Cuándo se construyó la primera computadora? Eso depende de dónde se dibuja la línea entre las computadoras y los no-computadoras.

Hace 20.000 años la gente cortaba patrones de muescas en los huesos de los animales. Algunos expertos creen que los palos de conteo se utilizaron para realizar cálculos aritméticos.

El ábaco es un dispositivo de computación inventado hace unos 4.000 años. Las personas que están bien entrenadas para usarlo pueden realizar cálculos con notable rapidez, incluyendo raíces cuadradas y cúbicas en números de varios dígitos. En algunos países, el ábaco todavía se utiliza ampliamente hoy en día.

Desde la antigüedad, se han inventado muchos dispositivos informáticos especiales. Por ejemplo este planetario mecánico mostraba las posiciones de los planetas en el Sistema Solar. El primer dispositivo conocido de este tipo data de hace unos 2100 años. La gente de entonces creía que el sol y otros planetas giraban alrededor de la tierra, haciendo que las posiciones fueran muy complicadas de calcular, así que el mecanismo era mucho más difícil de diseñar y construir de lo que sería hoy en día.

Aquí hay un ejemplo moderno de un planetario mecánico.

En 1822, Charles Babbage diseñó un dispositivo al que llamó "Máquina diferencial". Hecho de engranajes metálicos fabricados con precisión, calcularía e imprimiría tablas de números, como funciones de registro o de trigonometría. Lee más en la página de arquitectura digital.

El motor de análisis podía computar varias funciones fijando manualmente la posición inicial de sus engranajes, pero sólo tenía un algoritmo, incorporado en el diseño del hardware. En 1833, Babbage comenzó un proyecto más ambicioso, el motor analítico. Se basaba en la idea general de la máquina diferencial, pero con una diferencia crucial:Podía llevar a cabo instrucciones en un lenguaje de programación primitivo, preparado en tarjetas perforadas. Lee más en la página de arquitectura digital.

El diseño de Babbage era muy versátil, pero su interés seguía siendo principalmente en la impresión de tablas de números. Fue su colaboradora Ada, la Condesa Lovelace, quien primero reconoció que los números en la computadora de Babbage podían ser usados no sólo como cantidades sino también como representación de notas musicales, caracteres de texto, etc. Lee más en la página de arquitectura digital.

Bueno, estamos exagerando. Mucha gente contribuyó a la derrota nazi. Pero no todos eran soldados; algunos eran matemáticos. Turing, que desarrolló las primeras ideas de la informática y probó el Teorema de la Detención, que viste en Unidad 5, Laboratorio 4: Un problema indeterminado, fue el líder de un equipo británico de matemáticos que hizo un gran avance en el descifrado de mensajes encriptados con la máquina británica Enigma.

El criptoanálisis de Enigma permitió a los aliados occidentales en la segunda guerra mundial leer cantidades sustanciales de radiocomunicaciones secretas en código Morse de las potencias del eje. El Comandante supremo aliado occidental Dwight D. Eisenhower consideró que la inteligencia militar de esta y otras transmisiones de radio y teleimpresión descifradas del eje eran "decisivas" para la victoria aliada.

Alan Turing, un matemático y lógico de la Universidad de Cambridge, proporcionó gran parte del razonamiento original y diseñó el dispositivo. El ingeniero Harold "Doc" Keen convirtió las ideas de Turing en una máquina de trabajo. (adaptado de El criptoanálisis de Enigma, Wikipedia CC-BY-SA)

La primera demostración pública en 1968 de un ratón, colegas separados por millas trabajando en la misma pantalla, y muchas otras tecnologías que ahora damos por sentadas, fue tan sorprendente para el público que se conoció como "la madre de todas las demostraciones". (Sólo hay que buscar ese nombre en Wikipedia o YouTube.)

El inventor de este sistema, Douglas Engelbart, se interesó durante toda su vida en el uso de la tecnología para aumentar la inteligencia humana, en particular para apoyar la colaboración entre personas físicamente distantes. Estudió a las personas que hacían trabajos intelectuales y observó que cuando no están usando una computadora no se sientan rígidamente frente a sus escritorios, sino que llevan sus sillas alrededor de la habitación mientras agarran libros o simplemente piensan. Así que diseñó una silla de oficina con un tablero portátil que contenía un teclado y un ratón—el primer ratón. También inventó una forma de que la gente colaborara en la misma página al mismo tiempo, viendo los cursores de los ratones de los demás. Los documentos creados en el sistema tenían hipervínculos a otros documentos, mucho antes de que se inventara la Web y se utilizara esta idea. También hubo muchas primicias más pequeñas, como una pantalla de la cámara de la cara de la otra persona, mucho antes de Skype. La gente recuerda a Engelbart principalmente por el ratón, pero fue pionero en muchas características de la moderna interfaz gráfica de usuario (IGU).

El proyecto de tesis doctoral de Ivan Sutherland en 1963, un programa para ayudar a dibujar planos de puntos, segmentos de líneas y arcos de círculos, fue pionero tanto en la programación orientada a objetos como en la capacidad de dibujar en una pantalla (usando un bolígrafo de luz; el ratón no había sido inventado aún).Fue uno de los primeros programas con una interfaz gráfica de usuario interactiva, para que la gente que no era programadora pudiera usarlo fácilmente.

Busca "Sketchpad" en YouTube para ver una demostración de este software.

La Agencia de Proyectos de Investigación Avanzada (APIA) del Departamento de Defensa de los Estados Unidos fue y sigue siendo el principal financiador de la investigación informática en los Estados Unidos. Desde finales de los años 60 hasta principios de los 80 apoyaron el desarrollo de una red que conectaba principalmente a las universidades con los proyectos financiados por ARPA, junto con algunas bases militares. La red inicial en 1969 consistía en cuatro computadoras, tres en California y una en Utah. En su apogeo, alrededor de 1981, había alrededor de 200 computadoras en la red. Con un número tan reducido de computadoras, cada una de ellas conocía el nombre y el "número de host" de todas las demás. Se utilizaron computadoras de entrada especiales llamadas PMIs (Procesadores de Mensajes de Interfaz) para conectar las computadoras anfitrionas a la red, como un router de hoy en día.

Sólo las organizaciones con becas de investigación de ARPA podían estar en la red. Esto significaba que casi todos los sitios de la red eran universidades, junto con un pequeño número de empresas de tecnología que trabajaban para ARPA. Todos se conocían entre sí, y así la red se construyó alrededor de la confianza. Se alentaba a las personas a utilizar los recursos de otros sitios; había un directorio publicado anualmente de todas las computadoras de la red, que incluía, para la mayoría de ellas, información sobre cómo iniciar sesión como usuario invitado. Era un espíritu mucho más amigable que el de la Internet actual, con millones de computadoras y millones de usuarios que no se conocen ni confían unos en otros. Pero el espíritu amigable fue posible sólo porque el acceso a ARPANET estaba fuertemente restringido.

Los arquitectos de ARPANET sabían que un sistema que requería que cada computadora supiera la dirección de todas las demás no iba a funcionar en una red accesible para todos. Su plan era construir una red de redes— Internet. La batería de protocolos TCP/IP fue diseñada y probada en la ARPANET.

Poco a poco la ARPANET se dividió en piezas. Las primeras grandes piezas fueron MILNET para las bases militares y NSFnet, establecida en 1986 por la Fundación Nacional de Ciencia, para los sitios de investigación. Esta división fue el comienzo de Internet. Se crearon redes regionales más pequeñas. Las empresas de comunicación como AT&T crearon redes comerciales a las que cualquiera puede unirse. El acceso a la red se extendió por todo el mundo a través de la radio satelital y de los cables submarinos. En 1995 la NSFnet fue abolida, y todo el mundo se conectó a la red a través de proveedores de servicios de Internet comerciales.

En los primeros días de la red, los principales protocolos a nivel de aplicación eran Telnet, que permitía a un usuario conectarse a distancia a otra computadora, y FTP (Transferencia de protocolo de archivos), para copiar archivos de una computadora a otra. El FTP es genial si ya sabes lo que estás buscando, y exactamente dónde está en el sistema de archivos de la otra computadora.

Varias personas tuvieron la idea de un sistema que permitiera a los usuarios incrustar enlaces a archivos en una conversación, así que se podría decir "Yo creo que este documento podría ayudarte." En 1945, Vannevar Bush describió un hipotético dispositivo con la capacidad de incrustar enlaces en archivos. En 1963, Ted Nelson inventó la palabra "hipertexto" como nombre para esta característica, pero la primera implementación real fue el sistema NLS de Douglas Engelbart, desarrollado a partir de 1963 y demostrado en 1968.

En 1989, el físico Tim Berners-Lee implementó un sistema de hipertexto y lo llamó la red mundial de internet (en inglés World Wide Web) . Al principio sólo fue utilizado por los físicos, para compartir datos e ideas. Pero para entonces la Internet ya estaba funcionando, por lo que su momento fue el adecuado, y el nombre era mucho más atractivo que el "hipertexto" de sonido técnico (aunque, como se vio en Unidad 4, Laboratorio 3: Jerarquía de protocolos abiertos,entre bastidores, el protocolo que hace funcionar la Web se llama "Protocolo de Transferencia de Hipertexto" o PTH). El crecimiento de la web fue muy rápido, de unos 500 servidores en 1993 a más de 10.000 en 1994. Hoy en día, mucha gente habla como si "Internet" y "la Web" fueran la misma cosa, pero has aprendido que no lo son en Unidad 4, Laboratorio 1: ¿Qué es Internet?.

La visión de Berners-Lee era de una red en la que todos serían a la vez creadores y consumidores de información. Pero la red se convirtió rápidamente en una comunicación unidireccional, con unos pocos sitios de Internet comerciales obteniendo la mayor parte del tráfico. Hoy en día, la mayoría del tráfico de Internet va a Google, Facebook, CNN, Amazon, y algunos otros. Pero cierto grado de democracia regresó a la web con la invención del blog (abreviatura de "registrode la red") en el que la gente común puede publicar sus opiniones y esperar que otras personas las noten.

El primer dispositivo que podría considerarse un teléfono inteligente se demostró en 1992 y estuvo disponible para la venta en 1994. Pero a través de los años 90, la gente que quería dispositivos digitales portátiles podía obtener un teléfono celular sin aplicaciones, y un "asistente digital personal" (ADP) que funcionaba con aplicaciones pero no podía hacer llamadas telefónicas. Alrededor de 1999, unas pocas empresas desarrollaron dispositivos con el teléfono y la ADP en una sola carcasa, compartiendo la pantalla pero esencialmente dos computadoras separadas en una caja. El Kyocera 6035, en la foto, era un teléfono con la solapa cerrada, pero era una ADP piloto de palma con la solapa abierta.

Fue a finales de la década de 2000 que las dos funciones de un teléfono inteligente se combinaron en un solo procesador, con el marcador telefónico como un solo programa de nivel de aplicación.

Los programadores han tratado de diseñar y construir programas de ajedrez desde al menos 1941 (Konrad Zuse). Durante la década siguiente, varios de los principales investigadores en Ciencias de la Computación (incluyendo a Alan Turing, en 1951) publicaron ideas para algoritmos de ajedrez, pero los primeros programas que se ejecutaron realmente llegaron en 1957. En 1978, un programa de ajedrez ganó una partida contra un campeón de ajedrez humano, David Levy, pero Levy ganó la partida de seis juegos 4½-1½. (Los medios puntos significan que una partida fue un empate.)

Sólo hay infinitas posiciones de ajedrez posibles, así que en principio un programa podría trabajar a través de todos los juegos posibles y producir un diccionario completo del mejor movimiento posible para cada jugador en cada posición. Pero hay cerca de 1043 posiciones en el tablero, y en 1950, Claude Shannon estimó que hay cerca de 10120 posibles juegos,mucho más allá de la capacidad de las últimas y más rápidas computadoras. Los programas de ajedrez, al igual que los jugadores humanos, sólo pueden calcular todos los resultados posibles de las próximas jugadas, y deben entonces hacer suposiciones informadas sobre qué resultado posible es el mejor.

Un punto de inflexión en el ajedrez informático llegó en 1981, cuando el programa Cray Blitz fue el primero en ganar un torneo, derrotar a un campeón de ajedrez humano y obtener una puntuación de campeón de ajedrez para sí mismo. Al año siguiente, el programa Belle se convirtió en el segundo programa de computadora con una calificación de campeón de ajedrez. En 1988 dos programas de ajedrez, HiTech y Pensamiento Profundo, vencieron a grandes campeones de ajedrez humano.

En 1997, Deep Blue, una computadora de propósito especial construida por IBM sólo para jugar al ajedrez, con 30 procesadores más 480 CI de propósito especial para evaluar posiciones, venció al campeón mundial de ajedrez Garry Kasparov en una partida de seis partidos, 3½-2½. Su hardware especial permitió a Deep Blue evaluar 200 millones de posiciones de tablero por segundo.

En 2006, el campeón mundial de ajedrez Vladimir Kramnik fue derrotado por 4-2 en una partida de seis juegos por Deep Fritz, un programa de ajedrez que funciona en una computadora ordinaria. Aunque el marcador parece abrumador, una de las partidas que Deep Fritz ganó fue casi una victoria para Kramnik, quien no pudo ver una jugada ganadora para sí mismo y en su lugar preparó la computadora para un jaque mate de una jugada. Sin este error garrafal, la partida habría estado empatada 3-3.

Los programas de ajedrez siguen mejorando. En 2009, el programa Pocket Fritz 4, que funciona con un teléfono móvil, ganó un torneo y alcanzó la calificación de gran campeón. El programa, a diferencia de Deep Blue, sólo podía evaluar 20.000 posiciones por segundo, por lo que esta victoria muestra una mejora en la estrategia, no sólo una mejora en la velocidad de la computadora de fuerza bruta.

Siri es el software de asistente personal de Apple.Fue lanzada por primera vez como una aplicación de terceros en la tienda de aplicaciones en 2010; Apple compró la compañía que la hizo, e incluyó a Siri como parte de iOS en 2011.

Siri no fue el primer programa que entendía el habla. Dragon Dictate, un programa de habla a texto fue lanzado en 1990. Los esfuerzos de los laboratorios de investigación comenzaron mucho antes; en 1952, un programa desarrollado en los laboratorios Bell fue capaz de entender los dígitos hablados. A medida que pasaba el tiempo, el número de palabras comprendidas por los programas aumentó. En 2002, Microsoft introdujo una versión de sus programas de Office (incluyendo Word) que aceptaba dictados hablados.

En 2006, la Administración de Seguridad Nacional (ASN) comenzó a utilizar programas informáticos para reconocer palabras clave en las llamadas telefónicas que espía.

La primera aplicación para teléfonos móviles que usó reconocimiento de voz fue la Búsqueda por Voz de Google en 2008, pero sólo introdujo las palabras que escuchó en una barra de búsqueda sin tratar de entenderlas. Lo nuevo de Siri no era el reconocimiento de voz, sino su capacidad de entender las frases que dicen sus usuarios como comandos para hacer algo: "Llama a Fred", "Haz una cita con Sarah para mañana a las 3pm", y así sucesivamente.

Las revisiones del desempeño de Siri en 2011 no fueron todas buenas. Tuvo problemas para entender los acentos del sur de EE.UU. o de Escocia. Tenía muchos problemas con las frases gramaticalmente ambiguas. Su conocimiento de los puntos de referencia locales era irregular. Sin embargo, provocó una nueva oleada de compradores de teléfonos Apple.

Más recientemente, Microsoft (Cortana), Amazon (Alexa) y Google (Asistente) han introducido programas de asistencia personal basados en el habla que compiten entre sí.

La realidad aumentada es una técnica en la que el usuario ve el mundo real, pero con imágenes o texto adicionales superpuestos. Aunque ya se había utilizado anteriormente, la primera gran exposición pública a la realidad aumentada fue en el juego Pokémon Go. Los jugadores caminan mientras miran las pantallas de sus teléfonos, que muestran lo que la cámara está viendo, pero con la adición ocasional de un personaje de dibujos animados para que el jugador lo atrape. Cada jugador que mira al mismo lugar ve el mismo personaje, porque el juego utiliza el GPS del teléfono para localizar al jugador.

La programación del juego fue impresionante, pero aún más impresionante fue el esfuerzo que los desarrolladores pusieron en colocar a los personajes de los dibujos animados en lugares de todo el mundo que sean accesibles, abiertos al público y no ofensivos. (Niantic, la compañía que desarrolló el juego, tuvo que eliminar algunos lugares de su lista debido a quejas, incluyendo cementerios y museos del Holocausto.)

El juego fue descargado más de 500 millones de veces en 2016, e, inusualmente para un videojuego, fue apoyado con entusiasmo por los padres de muchos jugadores, porque el juego saca a los jugadores de la casa, y hacen ejercicio caminando por ahí. Además, como los jugadores se reúnen en los lugares donde se encuentran los Pokémon, el juego fomentaba las amistades en la vida real entre los jugadores. Por otro lado, había problemas de seguridad, en parte porque los jugadores cruzaban las calles mirando sus teléfonos en lugar de estar atentos al tráfico, y en parte porque ciertos Pokémon se colocaban delante de los parques de bomberos, o en lugares que animaban a los jugadores a cruzar las vías del tren.

IBM puso por primera vez una computadora cuántica de cinco cúbits (bits cuánticos) en Internet en 2016 (ver Computadora cuántica - IBM Q - US), pero al año siguiente añadieron una computadora mucho más potente de 16 cúbits. (El cúbit es el equivalente para las computadoras cuánticas). Cualquiera puede usarlo, gratuitamente, aunque siempre hay una lista de espera para las citas.

La descripción habitual y simplificada de la Computación cuántica es que un cúbit (pronunciado "Q bit") es "tanto cero como uno al mismo tiempo." Está más cerca de decir que un cúbit es cero o uno, pero no sabemos cuál hasta que se examina al final de un cálculo, en cuyo momento se convierte en un bit ordinario con un valor fijo. Esto significa que una computadora cuántica con 16 cúbits no es tan poderosa como 216 computadoras separadas que intentan todas las combinaciones posibles de valores de bits en paralelo. Sabemos que ciertos algoritmos de tiempo exponencial pueden ser resueltos en tiempo polinomial por computadoras cuánticas, y sabemos que algunos otros no pueden, pero todavía hay un gran punto medio de algoritmos de tiempo exponencial para los que no sabemos lo rápido que pueden ser las computadoras cuánticas.

El IBM QX se ha utilizado para una amplia variedad de cálculos cuánticos, que van desde la investigación académica a un juego multijugador Quantum Battleship .